NUS News

Pegar uma lata de refrigerante pode ser uma tarefa simples para os seres humanos, mas isso pode ser muito complexo para um robô. Isso porque ele precisa localizar o objeto, deduzir sua forma, determinar a quantidade certa de força a ser usada e agarrar o objeto sem deixá-lo escorregar — tudo sem a sensibilidade de nossas mãos.

Alguns autômatos já realizam essas funções, que devem ganhar um grande reforço com um novo sistema cerebral artificial integrado, capaz imitar redes neurais biológicas. A novidade pode ser executada em um processador neuromórfico com eficiência de energia, como o chip Loihi da Intel.

O sistema também integra sensores artificiais de pele e visão, equipando os robôs com a capacidade de tirar conclusões precisas sobre os objetos que estão capturando, com base nos dados capturados em tempo real.

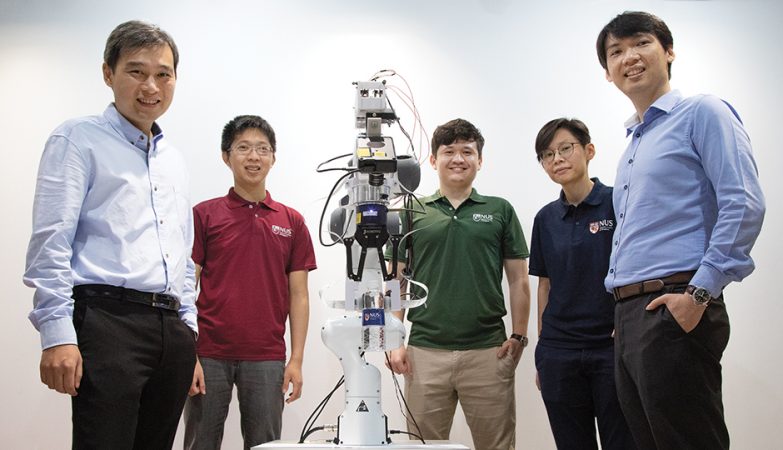

“O campo da manipulação robótica fez um grande progresso nos últimos anos. No entanto, a fusão de informações visuais e táteis para fornecer uma resposta altamente precisa em milissegundos continua sendo um desafio tecnológico”, diz Benjamin Tee, professor assistente do departamento de ciência e engenharia de materiais da Universidade Nacional de Singapura.

“Nosso trabalho recente combina nossas capas eletrônicas ultrarrápidas e sistemas nervosos com as mais recentes inovações no sensor de visão e inteligência artificial (IA) para robôs, para que eles se tornem mais inteligentes e intuitivos nas interações físicas”, complementa.

Em fábricas, por exemplo, os braços de autômatos equipados com capas eletrônicas poderiam se adaptar facilmente a diferentes itens, usando sensoriamento tátil para identificar e segurar objetos desconhecidos com a quantidade certa de pressão para evitar escorregões.

Para chegar a esse resultado, os pesquisadores aplicaram uma pele artificial avançada chamada “pele eletrônica codificada assíncrona”, desenvolvida por Tee e seus colegas em 2019.

O sensor de detecção de toques é mais de mil vezes mais rápido do que o sistema nervoso humano e pode identificar forma, textura e dureza de objetos dez vezes mais rápido que um piscar de olhos.

“Criar um sensor de pele artificial ultrarrápido resolve cerca de metade do quebra-cabeça de tornar os robôs mais inteligentes. Eles também precisam de um cérebro artificial que possa finalmente alcançar a percepção e o aprendizado como outra peça crítica do quebra-cabeça”, diz Tee.

Como eles criaram o sistema?

Para processar dados sensoriais em uma pele artificial, os pesquisadores exploraram a tecnologia neuromórfica, uma área da computação que emula a estrutura neural e a operação do cérebro humano – para processar dados sensoriais da pele artificial.

Como Tee e seu colega Harold Soh, professor assistente do departamento de ciência da computação, são membros da Comunidade de pesquisa neuromórfica da Intel, eles dizem que foi uma escolha natural usar o chip de pesquisa neuromórfica Loihi da fabricante para seu novo sistema robótico.

Nos experimentos iniciais, os pesquisadores ajustaram uma mão robótica à pele artificial e a usaram para ler Braille, passando os dados táteis para Loihi através da nuvem para converter os microchoques que a mão sentiu em um significado semântico. Loihi alcançou mais de 92% de precisão na classificação das letras em Braille, enquanto usava 20 vezes menos energia que um microprocessador normal.

A equipe de Soh, então, combinou dados de visão e toque em uma rede neural para melhorar os recursos de percepção do robô. Em um dos experimentos, um autômato equipado com o sistema classificou vários recipientes opacos contendo quantidades diferentes de líquido. Eles também testaram a capacidade do sistema de identificar o escorregamento rotacional, importante para uma apreensão estável.

Nos dois testes, a rede neural que utilizava os dados de visão e toque foi capaz de classificar objetos e detectar o deslizamento — foi 10% mais precisa do que um sistema que usava apenas visão.

Com o uso de uma técnica desenvolvida pela própria equipe, as redes neurais conseguiram classificar os dados sensoriais enquanto estavam sendo acumulados — diferente da abordagem convencional, em que os dados são categorizados após a coleta completa. Além disso, os pesquisadores o Loihi processou os dados sensoriais 21% mais rápido e usou 45 vezes menos energia que uma unidade de processamento gráfico de melhor desempenho.

No futuro, Tee e Soh planejam desenvolver ainda mais seu novo sistema robótico para aplicações nas indústrias de logística e manufatura de alimentos, onde há uma alta demanda por automação robótica, principalmente no cenário pós-COVID. A pesquisa foi apresentada na conferência Robotics: Science and Systems, neste mês, e desde já é promissora.

// Canaltech